工業技術研究院 資訊與通訊研究所 黃維中副所長

可信任的AI治理已成為全球民主國家、國際組織高度重視議題,AI風險管理框架與評測體系將引領產業跨入與國際接軌。

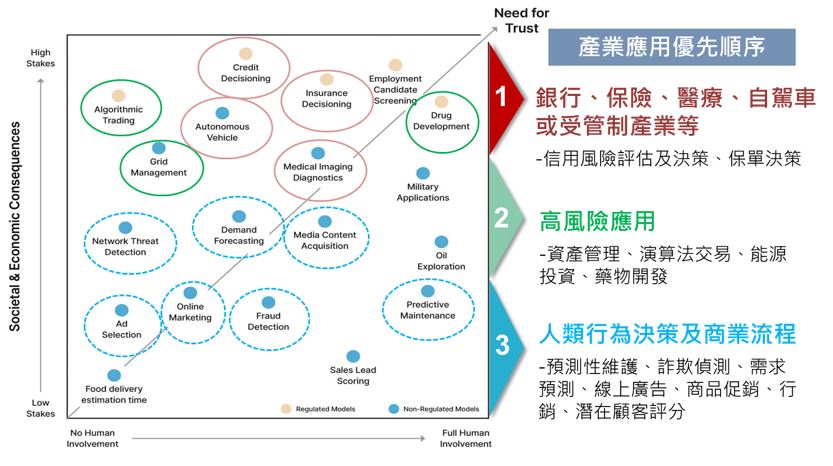

AI為企業帶來價值,應用廣泛擴散於商務、製造、金融、健康醫療、交通運輸等產業,成功協助企業進行分析與決策。但也引發一些問題,包括資料偏見、隱私保護與安全、系統透明化、可解釋性等。

企業AI落地尚缺臨門一腳:演算法的信任危機

在帶給人們生活方便的同時,AI也衍生了安全風險議題,進而造成信任危機。例如在醫療病情診斷上,醫師該如何向病患解釋AI輔助判讀成因,金融證券行員如何向客戶解釋投資交易決策,自駕車為何判斷失常而造成意外事故憾事,抑或警政罪嫌分析出現的性別與種族歧見等。人們迫切地想要掌握人工智慧演繹的邏輯依據,以對模型推論結果產生信任,建立「可信任AI」(Trustworthy AI)將對人工智慧技術落地與產業應用深化至關重要。

圖1 可信任AI在產業應用優先順序建議(資料來源:truera,工研院產科國際所整理)

繼2019年經濟合作暨發展組織(Organisation for Economic Cooperation and Development, OECD)頒布「AI原則」[1],美國政府也在2019年提出「美國人工智慧倡議」、2020年發布「人工智慧應用監管指南」,將可信任AI的準則列為重點;隨後更頒布13960號行政命令,以確保AI用途符合國家價值觀並有益於公眾利益。2021年歐盟執委會也提出了「人工智慧法」(Artificial Intelligence Act)草案,為全球第一個對人工智慧之現象與風險所做的立法嘗試。隨著AI的治理發展陸續受到各國重視,全球人工智慧領域專家紛紛投入研究確保AI的可信任性,與其可能帶來的安全風險;並為了達成可信任AI的長遠目標,開始展開國際標準規範制定,以系統性方式評測AI的效能與風險,要打破深度學習、機器學習所帶來的AI演算法黑箱(Black Box)。

AI系統可信度的衡量與潛在特徵解析

人工智慧產品服務係利用機器學習或深度學習方法,來發現數據模式、提出建議或採取行動,這些方式並不總是容易被消費者理解、預測或解釋,加上運行AI任務過程中經常與使用者之間高度互動,其複雜性和不可預測性讓一般大眾對於AI技術的信任與長期採用上更具挑戰。有鑑於此,美國國家標準與技術研究院(National Institute of Standards and Technology,NIST)積極投入於評估和強化人工智慧系統可信度的工作,並於2021年提出了一項評估用戶對於AI系統信任度的倡議(NISTIR 8332)[2],引領關於人們如何信任AI系統的討論。NIST認為核心議題在於對人工智慧系統的信任是否可被準確地與適當地衡量,並列出了有助於人們對AI系統潛在信任的九個特徵因素,涵括技術、社會環境、指導原則等層面,來權衡AI任務本身和信任人工智慧決策所涉及的風險。

準確性(Accuracy):為人工智慧系統的效能指標,取決於在特定任務目的上的服務品質。

可靠性(Reliability):係指系統在規定條件與時間內,達成其應具備功能的能力。 韌性(Resiliency):可定義為人工智慧系統面臨複雜且多變的環境時,其維持可穩定運行的適應能力。

客觀(Objectivity):人工智慧系統發展過程須使用未被偽造或遭受損壞的數據。

安全防護(Security):以資訊安全面向為主,如透過實體防護和安全管控措施,來保護資訊免受未經授權的訪問、使用、披露、中斷、修改或破壞。

可解釋性(Explainability):係指人工智慧推論結果如何被人們理解,與深度學習中無法解釋AI系統決策原因的黑箱概念為強烈對比。

安全狀態(Safety):指系統運行時不會造成不可接受的人身傷害或健康損害風險。

問責制(Accountability):涉及可追溯性或提供與特定案例相關的事件記錄。

隱私性(Privacy):隱私涉及個人資訊的蒐集、處理、共享、儲存和刪除,並隨著數據類型、使用情況,以及其他相關因素而異。

這些影響潛在信任的因素組合與權重,可能會因為使用AI系統的方式,以及特定應用所涉及的風險層級影響而有所差異;例如,即便得到相同的潛在信任特徵分數評比,人們可能只會願意信任音樂推薦演算法(低風險任務),而非用於診斷癌症的醫療AI助理(高風險任務)。NIST透過對於可信任AI的特徵拆解與量化解析,來嘗試了解人們在使用AI系統或受到AI系統影響時如何體驗信任程度,以協助精進可信任的AI系統發展。

圖2 即使具有相同的潛在特徵分數,仍因風險偏好存在AI信任差異(資料來源:NIST)

先進國家以風險管理框架推進可信任AI發展

為了因應AI治理趨勢發展帶來的諸多挑戰,諸如偏見、公平性、可解釋性和隱私防護等,NIST在美國國會指導下,2021年起積極研議AI風險管理框架(AI Risk Management Framework,AI RMF)[3],透過邀請公眾參與以建立對於風險識別、衡量和最小化的操作程序與有效框架,來管理人工智慧生命週期相關的風險、培養對AI的信任,期盼在可信任AI的模型基礎下,讓人工智慧應用具備公平性、安全性,及可解釋性。由於人工智慧的風險可能來自於訓練AI模型的數據、AI系統本身、以及系統的使用或人們與系統間的互動,NIST人工智慧風險管理框架希望透過彈性的、結構化的和可衡量的過程,幫助機構管理人工智慧生命週期發展,在設計、開發、評估和使用具有影響力的AI系統時發揮槓桿作用,增進理解、檢測、預防和降低相關企業與社會風險。

NIST人工智慧風險管理框架旨在將AI原則「轉化為設計人員、開發人員和評估人員可以用來測試可信任AI系統的技術要求」,目前AI RMF框架預計於2023年初完成制定,其第一部分「動機」描述了人工智慧風險管理程序的背景,將風險定義為「衡量受到潛在情況或事件負面影響的程度」;第二部分「核心和概要」則說明人工智慧風險管理的功能並為對應行動提供指導,如對映(Map)、衡量(Measure)、管理(Manage)和控制(Govern)等,以實現人工智慧的利益最大化和風險最小化;正在發展的第三部分「實踐指引」將提供在人工智慧產品、服務和系統開發和部署之前、期間和之後,可用來幫助使用框架指引的實務應用案例。AI RMF框架和相關資源將依據技術演進、全球標準制定,以及利益相關者的回饋持續更新、擴展與精進。

圖3 人工智慧風險管理框架發展重點產出與時程規劃(資料來源:NIST)

台灣推動建構AI評測體系與國際接軌

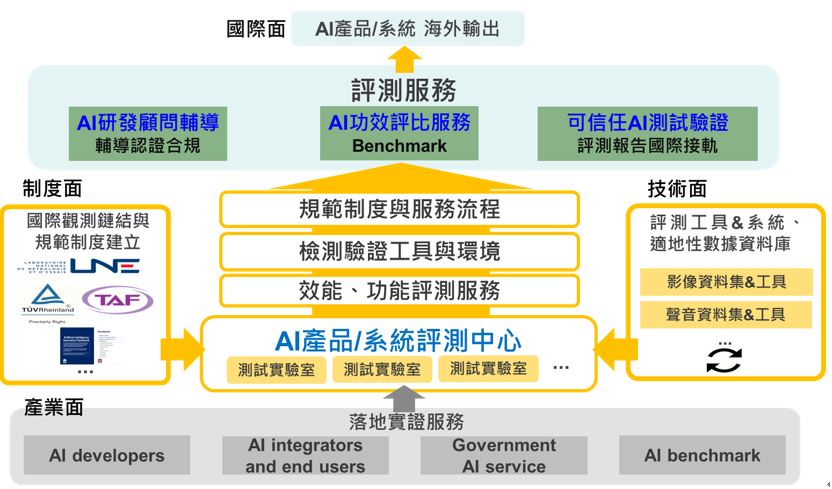

根據2021年研調機構Oxford Insights針對各國政府人工智慧整備度(Government Artificial Intelligence Readiness Index)的評估報告[4],綜合分析來自政府、技術部門、數據與基礎建設等面向指標,台灣在全球160個國家中排名第18、在東亞國家地區則排名第五,人工智慧正在迅速成為世界各國領導人最關切的議題。近年來,我國政府與民間均積極投入AI研發與應用,而為持續推動台灣產業化AI發展,更需進一步發展AI產品的相關標準與AI產品認驗證指引,並且接軌國際相關標準與規範、落實AI治理。工研院身為國家級智庫機構,正積極協助政府規劃台灣AI行動計畫的下一步,將聚焦可解釋、可信任AI,包括參考國際標準來制定AI產品驗證規範、建立模型測試和評估方法。透過搭建AI治理基礎設施,如建立AI測試和評估中心來衡量AI風險、模型表現和穩健性;以及打造AI產品驗證機制來推動產業發展、加速AI落地。

為了完善AI治理運作環境,將參酌國際標準組織制定的AI標準,與NIST美國國家標準與技術研究院、LNE法國國家計量測試實驗室架構,來建置我國AI產品及系統的評測中心(AI Testing and Assessment Center);透過提供涵括資料面、演算法、模型面等各項評估與測試技術工具,以評估AI產品系統自研發到應用導入階段的風險、效能和穩健性。同時,亦將規劃建立AI產品認驗證體系(AI Product Certification Scheme),依循特定的國內外標準,並由通過遵循ISO 17025、ISO 17065、ISO 17011等品質管理系統國際標準的測試實驗室與驗證機構(certification bodies)來進行測試驗證,帶動國內AI產業發展。未來更將鏈結國際,發展我國的AI指引與標準,以推動台灣可信任AI產品輸出國際市場,提供我國AI國際影響力。

圖4 政研機構共同規劃與推動成立AI產品/系統評測中心與服務(資料來源:工研院資通所)

參考文獻

[1] OECD AI Principles [Online]. Available at: https://oecd.ai/en/ai-principles

[2] Trust and Artificial Intelligence (NISTIR 8332) [Online]. Available at: https://nvlpubs.nist.gov/nistpubs/ir/2021/NIST.IR.8332-draft.pdf

[3] AI Risk Management Framework 2nd Draft [Online]. Available at: https://www.nist.gov/document/ai-risk-management-framework-2nd-draft

[4] Government AI Readiness Index [Online]. Available at: https://www.oxfordinsights.com/government-ai-readiness-index2021