圖一:AI 模型攻擊是一個相當危險、需要及早關注的議題。(影像來源:國立中央大學機械工程學系林智揚教授)

廖珮君|科技大觀園特約編輯

生成式 AI 的出現,快速推動社會進步同時,也有越來越多人開始反思「AI 安全」的重要性。隨著駭客攻擊手法升級,攻擊的目的不再是竊取資料,還能做到混淆 AI 的眼睛,例如讓自駕車 AI 模型把紅燈辨識成綠燈,造成生命安全的威脅。如何保護 AI 模型的安全,成為 AI 發展延伸的重要資安議題。

「就像人腦一樣,AI 機器大腦也可能會被誤導,」國立中央大學機械工程學系林智揚教授形容,AI 就像一個聰明又單純的大學生,腦袋和能力很好,但因為缺乏社會經驗所以很容易被騙,而在現實中有很多種方式都可能會影響 AI 的辨識能力,使其做出不正確的判斷。

以攻擊模式、目標及場景區分的 6 種 AI 模型攻擊

究竟 AI 模型可能會遇到哪些攻擊?林智揚認為,從攻擊模式、攻擊目標及攻擊場景三個面向分類,共有 6 種 AI 模型攻擊。以攻擊模式而言,可以分成「黑箱攻擊」與「白箱攻擊」。黑箱攻擊是指攻擊者在不知道 AI 模型架構、參重權數等資訊的情況下發動攻擊;而白箱攻擊主要針對已經公開數據資訊的 AI 模型進行攻擊,模型訓練細節的開放不僅會提升攻擊成功率,受歡迎的 AI 模型也會遭受較高的攻擊風險。

從攻擊目標來看,可以分成「無目標攻擊」與「有目標攻擊」。無目標攻擊是指透過攻擊影響 AI 模型的辨識能力,例如:讓一個負責識別汽車的 AI 模型,將汽車識別成蘋果、動物等其他物品;而有目標攻擊不只影響 AI 模型的辨識能力,更進一步要求 AI 需辨識成特定物品,延續前面汽車辨識 AI 模型的例子,有目標攻擊會指定將汽車辨識成蘋果。林智揚表示,有目標攻擊的安全風險很高,尤其現今很多汽車都導入影像辨識系統,協助判斷車外的道路狀況,如果有心人士攻擊這些影像辨識模型,使其將紅燈辨識成綠燈、將有人經過辨識成無人經過等,將會造成交通大亂,甚至威脅生命安全。

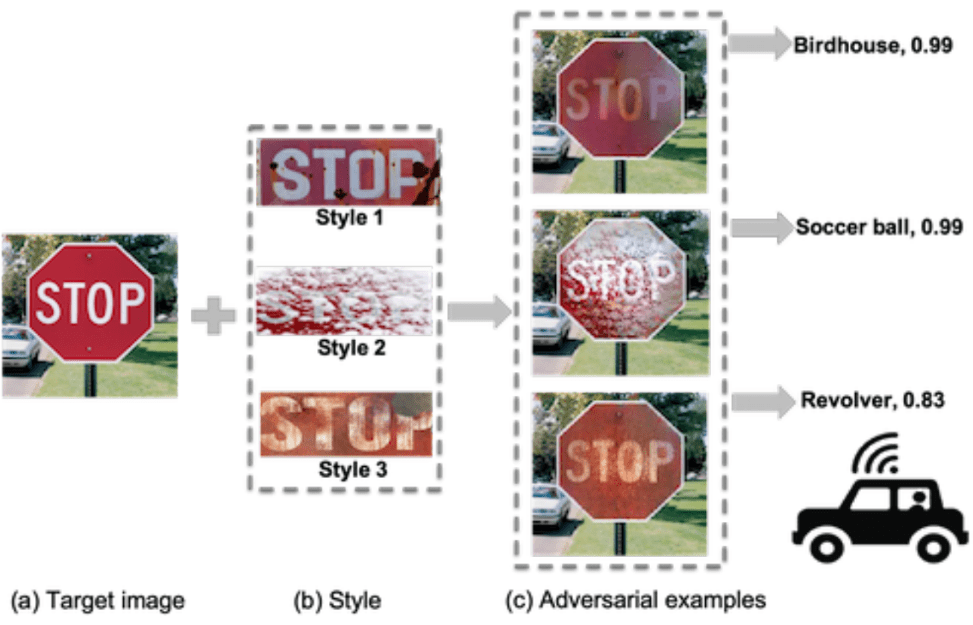

從攻擊場景來看,可以分成「數位世界攻擊」與「實體世界攻擊」。數位世界攻擊是指攻擊目標或場景在數位世界之中,例如:在一張熊貓影像加入肉眼看不出來的雜訊,就能讓 AI 模型將熊貓辨識成長臂猿;而實體世界攻擊則將攻擊目標或場景限縮在實體世界,例如:拿著印有人臉的紙張去誤導臉部辨識模型,又如讓 AI 模型把實體 STOP 號誌牌辨識成鳥巢或其他物體。

圖二:攻擊者透過實體世界攻擊,使 AI 模型將實體 STOP 號誌牌辨識成鳥巢或其他物體,造成交通混亂。(影像來源:Adversarial Camouflage: Hiding Physical-World Attacks With Natural Styles)

及早預防駭客攻擊,打造 AI 防禦安全網

為了進一步瞭解 AI 模型攻擊可能產生的風險,林智揚以臉部辨識模型進行攻擊測試,結果發現無論選擇數位世界或實體世界、針對單支或兩支攝影機的應用場景,都可以成功發動攻擊,讓 AI 將學生 A 辨識成學生 B。林智揚指出,現今臉部辨識模型通常應用於進出管制,且應用場域相當廣,如:手機或平板電腦開機、公司差勤、門禁管理等,倘若有心人士應用此類攻擊手法,讓 AI 把人臉辨識成另外一個人,建立在臉部辨識模型上的管控機制會失去其功能,故人們不可不慎重對待。

也因此,林智揚率領團隊投入 AI 模型防禦研究,並提出兩種破解攻擊的做法:一是去除攻擊資訊,由於雜訊是造成 AI 誤判的原因,過去許多研究者選擇想辦法直接去除雜訊,然而此種方式較為困難且跟不上攻擊更新速度,因此,林智揚逆向思考,運用煉鋼過程加入特定物質去除雜質的概念,先加上更強的雜訊後再一起去除雜訊。二是惡意樣本訓練法,針對每一種攻擊手法去產生惡意影像,使 AI 模型能夠辨別受到攻擊的圖片。

「雖然目前尚未傳出大型 AI 攻擊事件,也沒有造成社會重大影響,但 AI 模型攻擊其實是一個相當危險、需要及早關注的議題,」林智揚強調,產官學必須在 AI 模型攻擊造成大量傷亡前,事先築好防禦安全網,如:與學界進行技術合作,將 AI 攻擊防禦的研究成果整合至 AI 模型中,提升 AI 的防禦能力,讓人們可以安心享受 AI 帶來的便利。

資料來源:

● 採訪國立中央大學機械工程學系林智揚教授

● 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR):Adversarial Camouflage: Hiding Physical-World Attacks With Natural Styles